A nadie le gusta que le espíen, pero todos queremos ser protegidos. La tecnología de reconocimiento facial potencia ambas posibilidades. Por un lado reduce notablemente el crimen, facilita localizar personas desaparecidas y hace inviables los secuestros. Pero, ¿qué hay de la privacidad?

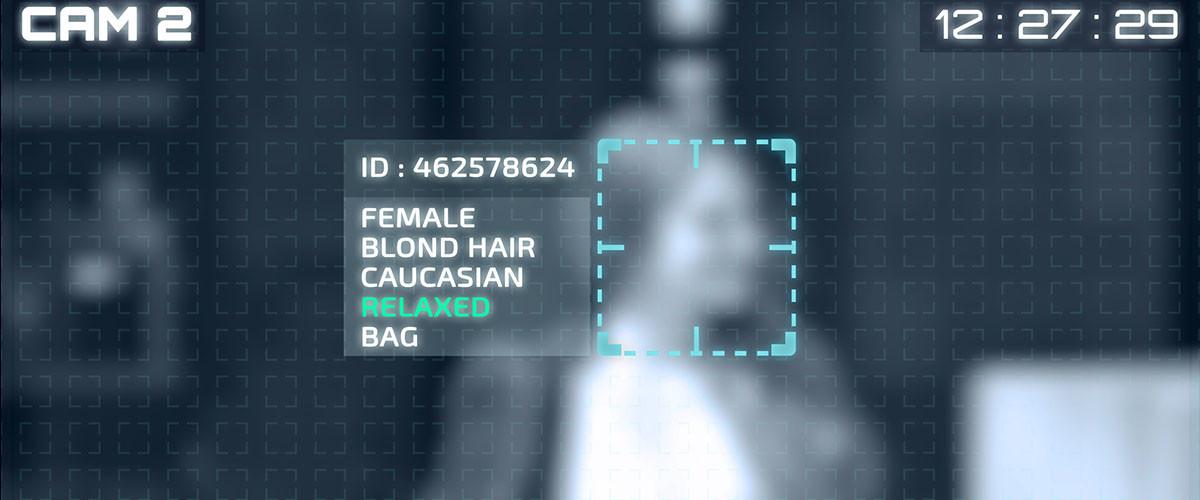

A la par que China despliega millones de cámaras (Face++) y Londres realiza sus primeras pruebas de reconocimiento facial en las calles de la ciudad (abajo), San Francisco aprueba en un pleno una ley en contra de que esta tecnología se use en sus calles junto a Massachusetts y el Congreso de los Estados Unidos.

Londres prueba su tecnología de reconocimiento facial

El vídeo de abajo muestra un breve reportaje de la BBC en redes sociales. Una serie de cámaras elevadas conectadas a un circuito cerrado escanean rostros. El equipo es de la policía, y su objetivo es localizar a personas específicas, aunque este caso concreto es un ensayo.

El dispositivo no es muy diferente del que ya existe para identificar matrículas e incluso rostros en aeropuertos. La diferencia radica en que, en lugar de mirar personas, “miran” máquinas. Y miran siempre. Las máquinas no se cansan, no descansan, no pestañean.

Are you ready for a world of facial recognition? Several UK police forces have been trialling the technology. pic.twitter.com/4LFLLEzSQe

— @bbcclick (@BBCClick) May 13, 2019

El vídeo muestra también el conflicto vecinal cuando alguien se niega a ser identificado por las cámaras. La situación es muy delicada porque, de hecho, en países como Inglaterra o España estamos obligados a identificarnos ante un agente de policía si este nos lo solicita (Ley Orgánica 4/2015). Algo que también ocurre en sentido contrario para identificar al agente (Real Decreto 1484/1987).

Pero, ¿tengo que identificarme ante una cámara? Técnicamente, también, aunque no estemos de acuerdo. El dispositivo londinense informaba a los viandantes de la prueba y, en materia legal, las cámaras eran una extensión de los ojos de los policías. Cubrirse el rostro era un claro indicio de desobediencia a la autoridad pública (en España art. 556 del Código Penal) sumado a conducta sospechosa.

Evitar el panóptico de Bentham

Pero que sea legal no quiere decir que esté bien. Hay muchos partidarios de frenar o prohibir esta tecnología de vigilancia. Para ello suele mencionarse el panóptico de Bentham, una estructura carcelaria del siglo XVIII en la que el preso podía ser observado en todo momento pero sin saber cuándo los guardias estarían pendientes de él. El resultado es una paranoia acentuada.

Aunque esto entra más en el campo de la filosofía, uno se comporta mejor (de acuerdo a las normas) cuando sabe que le están vigilando o cuando sospecha que alguien puede estar mirando. Nos comportamos bien aunque no queramos para evitar problemas con la autoridad. Ahora a esto lo llamamos autocensura.

Como dice Aaron Peskin, City Supervisor & Bill Sponsor en San Francisco, “es poco saludable a nivel psicológico cuando la gente sabe que cada aspecto de la vida pública está siendo vigilado: las calles, los parques…”. Peskin ha sido uno de los líderes contra la aplicación Rekognition, de Amazon.

Las palabras de Ivan Balhatchet, de la policía londinense, también resultan acertadas cuando, al defender esta tecnología dice que “somos conscientes de algunas de las preocupaciones generadas por lo que estamos haciendo en estas pruebas”. Es importante tener en cuenta la percepción social.

La tecnología sigue sin estar madura

Una de las críticas más duras contra el sistema no parte de la base del anonimato en lugares públicos o el estar siendo vigilado, sino de la tasa de error. La tecnología falla, y el problema es que falla en base a las diferentes etnias. Volvemos al tema de la programación ética y los sesgos.

Las diferencias faciales entre los bancos de ensayo de esta tecnología y la población general (casi no hay investigadores negros, por ejemplo) hace que la identificación falle mucho más si se es una persona de color. ¿Por qué? Porque los sistemas se han entrenado con personas blancas, a las que identifica con más éxito.

Varios ejemplos. El 40% de los fallos en la identificación del sistema Rekognition, de Amazon, falla al analizar fotografías con personas de color que solo representan el 20% del total de los experimentos según informa The Guardian.

Varios investigadores del MIT detectaron, además, que el 19% de las ocasiones este sistema clasificaba como varones a las mujeres y que el 31% de las veces confundía a mujeres de piel oscura con varones.

La tecnología está muy verde, y esto no es admisible. O bien las tasas de error disminuyen para todos en la misma proporción, siendo la etnia o el género irrelevantes para un falso positivo, o la tecnología aún no está lista para ser usada y necesitará más pruebas.

El estado de hipervigilancia

Lo cierto es que ya vivimos en un estado de hipervigilancia. Las grandes tecnológicas saben más sobre nuestros patrones en tiempo real que la policía. Google sabe dónde estás y qué haces en cada momento. Estamos acostumbrados a ello, lo hemos permitido sin pelear demasiado. O sin pelear nada.

El gran problema que aportan los críticos al sistema no es tanto psicológico sino político. Está demostrado que a la gente no le preocupa en demasía ser vigilada. A fin de cuentas ciudades como Londres, Madrid, Berlín, París, etc, tienen un fuerte dispositivo de vigilancia en sus cascos históricos, lo que no impide a vecinos y turistas acceder a la zona. Nos hemos acostumbrado a las cámaras.

Sin embargo, sí estamos preocupados por el uso que alguien podría hacer con esos datos. Y no solo un hacker u organización criminal. El fantasma de los sistemas totalitarios sigue presente en el mundo, y la información que pueda ser usada en nuestra contra en el futuro nos mantiene alerta.

En Lenovo | No me hace falta verte la cara: sé cómo caminas

Imágenes | iStock/pixinoo, iStock/Ekkasit919