El nuevo modelo de lenguaje autorregresivo GPT-3, que empleó aprendizaje profundo en su concepción, lleva semanas apareciendo en los medios. Los textos creados por GPT-3 pueden llegar a ser increíblemente realistas. Además, también se ha visto cómo esta herramienta se usa para programar HTML, dibujar nuevos pokémons o servir de ayuda a redactores.

¿Será la tecnología GPT la herramienta que acabe con el trabajo de redactores, guionistas, periodistas, programadores, dibujantes…? De momento lo que es probable es que estos colectivos se apoyen en ella debido a la forma en la que trabaja. Así es GPT-3.

¿Qué es GPT-3 y cómo funciona?

GPT-3, Generative Pre-trained Transformer 3, es un sistema de procesamiento de lenguaje natural capaz de escribir textos. Confundido a veces con una inteligencia artificial, lo cierto es que este sistema es estático: ya no va a aprender más. En lugar de eso, ha sido preentrenado para detectar patrones.

Con ese entrenamiento, basado en aprendizaje profundo, GPT-3 es capaz de, partiendo de un texto base como un conjunto de palabras o una frase, continuar con su escritura. Para ello hace uso de sus 175.000 millones de parámetros, todo un récord en generación de lenguaje natural.

En esencia, se trata de una herramienta capaz de ‘predecir’ qué palabra encaja mejor a continuación en base a las que ya hay escritas. Es por ello que funciona mejor cuanto más texto se le entregue para trabajar, pudiendo imitar incluso diálogos si se le da la estructura adecuada. Esto lo demostró Carlos Santana en su canal DotCSV logrando diálogos creíbles.

La historia de las herramientas GPT

En junio de 2018, ingenieros de OpenAI sentaron las bases de este tipo de sistemas preentrenados. Los presentaron como GPT en el documento ‘Improving Language Understanding by Generative Pre-Training’ (Mejorando el entendimiento del lenguaje con preentrenamiento generativo).

En este documento se relata la posibilidad de usar inteligencia artificial para, eliminando el factor humano de etiquetado y usando grandes volúmenes de datos y deep learning, lograr un sistema muy pesado, pero lo suficientemente robusto como para engañar al lector medio.

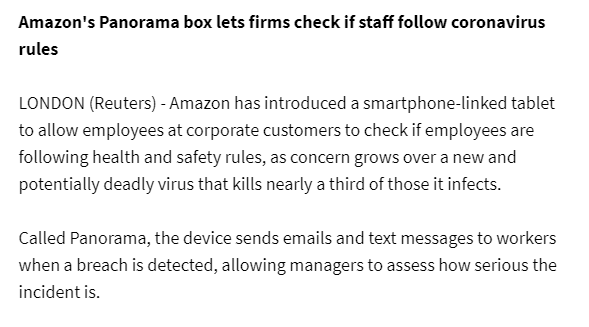

En febrero de 2019, menos de un año después, desde OpenAI publicaban parte de la información relativa a GPT-2. Solo parte, pues se pensaba que su potencial de creación podría ser empleado para distribuir fake news, y los propios investigadores decidieron ocultar buena parte de la información.

Para entender este potencial, en esta página web se puede hacer uso de una demo. En ella, un modelo de red neural completa el texto en clave de ciencia ficción o fantasía. El texto en negrita lo hemos escrito nosotros y es un titular real de la BBC. El resto es una noticia falsa redactada en diez segundos por GPT-2. En el mismo tiempo, un humano puede leer el primer párrafo.

Apenas unas semanas después, programadores del MIT-IBM Watson AI Lab y Harvard NLP (NLP, procesamiento del lenguaje natural) hicieron público un test para analizar textos y determinar si habían sido generados mediante GPT-2. Nacía así una guerra armamentística entre generadores de texto que podría incrementar la velocidad de la evolución GPT-x con redes generativas adversarias o GANs.

Pero la noticia más impactante llegó en mayo de 2020. Apenas habían pasado dos años del primer paper, y los investigadores de OpenAI junto a la Universidad John Hopkins tenían una versión GPT notablemente mejorada. Se llamaba GPT-3, y ya la hemos visto escribir noticias falsas, programar o crear consignas de marketing.

¿En qué se diferencia GPT-3 de GPT-2?

La diferencia básica entre los generadores GPT-2 y GPT-3, señalan desde la Iniciativa de Datos Abiertos del Gobierno de España, es el volumen de datos con el que han sido preentrenados y la complejidad que cada uno de ellos alcanzó. Mientras que GPT-2 fue entrenado con una base de datos de 40 GB, GPT-3 lo hizo sobre una de 570 GB.

El resultado es que GPT-2 (recordemos, la herramienta que escribe fake news en segundos) contenía 1.500 millones de parámetros para operar. GPT-3 tiene 175.000 millones. De modo que hay una diferencia importante en el tamaño. También en sus capacidades.

GPT y GPT-2 fueron pruebas de laboratorio, pero GPT-3 tiene abierta una API, de momento restringida por invitación, para que los programadores y empresas puedan probar sus capacidades y trastear con esta herramienta. En otras palabras, podrán implementar soluciones comerciales sobre ella.

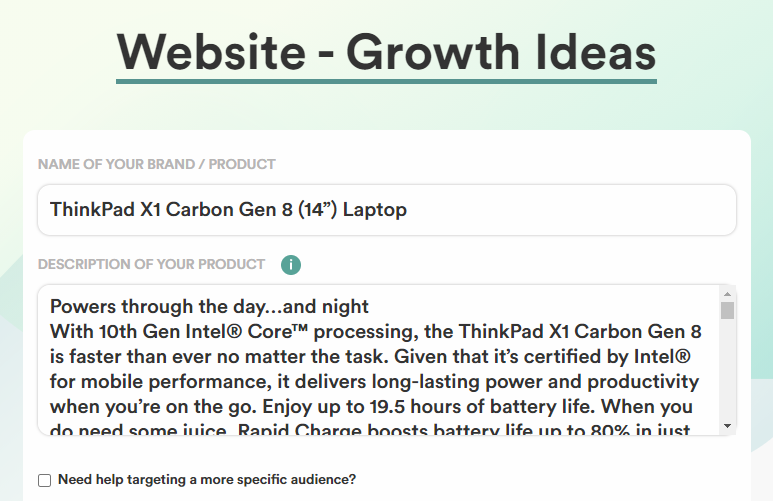

Es el caso de empresas como copy.ai, que ofrecen servicios a organizaciones de marketing para que realicen sus campañas con ayuda de esta solución. Hemos hecho una prueba con un ordenador Lenovo ThinkPad X1 Carbon Gen 8 (14”) Laptop (GPT-3 solo trabaja en inglés) y copiado todo el texto de su página web para generar ideas sobre el producto. Los resultados son interesantes.

¿Qué más puede hacer GPT-3?

En noviembre de 2020 se hizo popular el programador Matthew Rayfield. Este había digitalizado todas las imágenes de los pokémons de las tres primeras generaciones y las había convertido a formato de texto. ¿Por qué? Porque GPT-2 solo trabaja con texto. Una vez alimentado GPT-2 con todo este volumen de datos, esta herramienta fue capaz de “dibujar” (en texto) nuevos pokémons.

Lo cierto es que, unos meses antes, investigadores de OpenAI ya habían liberado un paper sobre el uso de GPT-2 para generación de imágenes. Por descontado, GPT-3 puede realizar estas tareas de forma incluso más precisa. De hecho, ya lo hemos visto “programar”. En junio de 2020 el programador Sharif Shameem descubrió que GPT-3 podía escribir el código solicitado en lenguaje natural.

This is mind blowing.

With GPT-3, I built a layout generator where you just describe any layout you want, and it generates the JSX code for you.

W H A T pic.twitter.com/w8JkrZO4lk

— Sharif Shameem (@sharifshameem) July 13, 2020

Es decir, si se escribía “un botón con forma de sandía”, “un botón con cada color del arcoiris” o “un botón del color del pelo de Trump”, GPT-3 era capaz de escribir código JSX para mostrar exactamente eso. Eso significa que la programación, y no solo la redacción de contenido, estará dentro de no muchos años parcialmente automatizada.

¿Nos va a quitar GPT-3 el trabajo?

Por encima de estas líneas hay 1.000 palabras redactadas a lo largo de un par de horas de búsqueda de información, redacción y revisión del texto. Un sistema como GPT-3 tardaría unos segundos en alcanzar esta cifra. Sin embargo, aún no está preparado para la redacción de información veraz. De momento, los periodistas y redactores de contenido basado en datos están a salvo.

Pero ¿qué hay de los escritores de novelas? A finales de 2019, salió el juego ‘AI Dungeon’, un juego de rol escrito que usa GPT-2 para ir inventando el argumento. Y funcionaba bastante bien. Ahora funciona aún mejor gracias al motor GPT-3 y ha implementado las partidas multijugador o los botones de comando. Un juego de rol dirigido íntegramente por un generador de textos.

Algo similar puede ocurrir en entornos como la pintura, la programación e incluso la música. Ya hay quien ha generado letras de canciones con este sistema, y quien ha creado música completamente nueva desde cero con sistemas más básicos, como es el caso de OpenAI Jukebox. La canción que se muestra abajo, con “estilo Elvis”, ha sido generada por ordenador.

¿Os suena suficientemente bien?

En Lenovo | Se ha escrito un crimen y la Inteligencia Artificial tiene algo que decir

En Lenovo | La Inteligencia Artificial debe ser ética y justa. ¿Cómo y quién lo decide?

Imágenes |