En enero de 2020, Robert Julian-Borchak fue detenido en Detroit por un delito que no cometió. El error se debió a un sistema de inteligencia artificial (IA) para el reconocimiento facial. Según el New York Times, fue el primer caso conocido de un ciudadano estadounidense arrestado por el error de un algoritmo.

Y es que nuestra vida ya está marcada por una cantidad increíble de decisiones algorítmicas, las cuales no son fácilmente controlables o gobernables. El 26 de febrero de 2021, el Washington Post informó que el ICE (la fuerza policial que controla la inmigración en los Estados Unidos) tenía acceso a una base de datos llamada CLEAR.

Esta incluye más de 400 millones de nombres, direcciones y registros de usuarios. Los datos proceden de 80 empresas que se ocupan de las facturas de agua, gas, electricidad, teléfono, internet y televisión por cable. Y se utilizan para combatir el fraude fiscal y sanitario o el blanqueo de capitales. Incluso para tomar decisiones sobre la custodia de los niños. Sin que los usuarios lo sepan, sus datos se cruzan y comparten.

En 2018, el problema fue abordado también por un informe del Center for Digital Democracy en Washington DC. La encuesta mostró que los sistemas de inteligencia artificial, como los asistentes virtuales, se basan en información recopilada través de prácticas domésticas digitales desordenadas, incompletas y contradictorias. Por lo tanto, la perfilación sobre la base de estos datos conduce inevitablemente a un análisis reduccionista e inexacto del comportamiento.

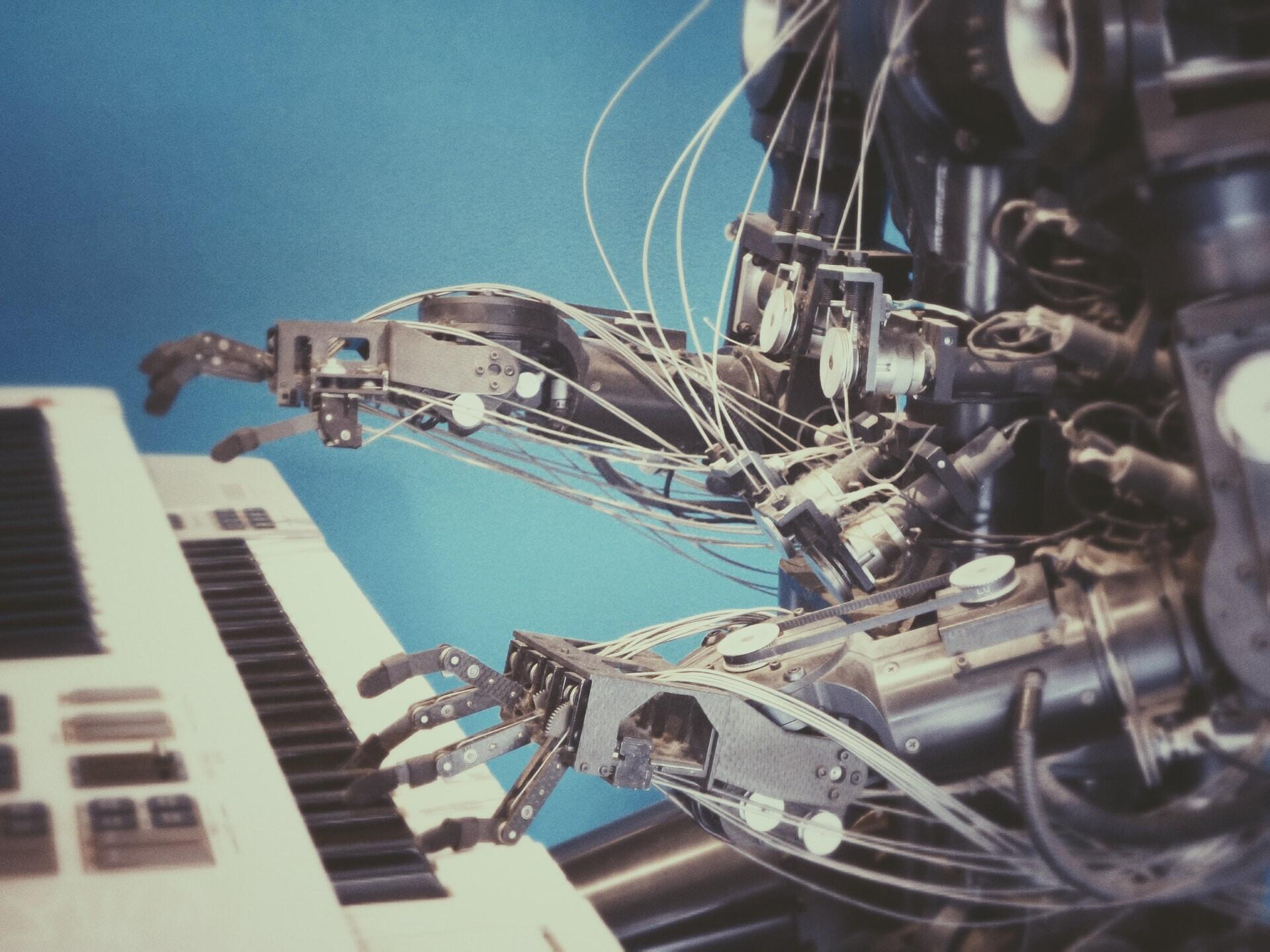

La inteligencia artificial es demasiado humana

En 2019, investigadores del AI Now Institute de Nueva York publicaron un informe sobre los usos policiales de las tecnologías de IA en Estados Unidos. Se descubrió que en varias ocasiones, el análisis predictivo se basaba en ‘datos sucios’, es decir: recopilados durante un período histórico en el que prácticas corruptas e ideologías racistas infestaban los cuerpos policiales.

Finalmente, en febrero de 2021, CNN publicó la noticia de un software de IA, llamado 4 Little Trees, utilizado en algunas escuelas de Hong Kong para analizar las expresiones faciales de los niños, determinar sus emociones e intervenir a nivel pedagógico. Unos días después, Kate Crawford, fundadora del AI Now Institute, escribió un artículo en Nature al respecto.

Crawford señala ahí que la ciencia detrás de la mayoría de estos sistemas de inteligencia artificial se basa en las teorías de Paul Ekman, según las cuales, existen seis emociones universales, innatas, transculturales y coherentes. Y se pueden leer a través del análisis de las expresiones faciales. Crawford cita a la antropóloga Margaret Mead para señalar que la teoría de Ekman no funciona porque no tiene en cuenta el contexto, la cultura y otros factores sociales.

Por lo tanto, por un lado, los algoritmos no pueden comprender la complejidad humana y terminan haciendo suposiciones simplistas e incorrectas sobre la intención detrás de una práctica digital. Por otro lado, los sistemas de IA no solo aprenden de datos descontextualizados, sino que también estas mismas bases de datos a menudo contienen muchos errores y prejuicios culturales y sociales.

Un problema de difícil solución

En abril de 2021, la Comisión Europea publicó la nueva Propuesta de Reglamento sobre inteligencia artificial. En ella considera a los sistemas de IA utilizados para la perfilación de las personas como de alto riesgo. Y sugiere la prohibición de prácticas como la puntuación social o la vigilancia biométrica en tiempo real.

Desafortunadamente, no existe una verdadera solución. Nuestras bases de datos no se pueden corregir con datos de valor absoluto porque solo reflejan el contexto social y cultural que las creó. Si realmente queremos comprender y limitar el impacto social de los sistemas de IA, debemos reconocer el error humano como algo inevitable.

La investigación The Human Error Project: AI, Human Nature and the conflict over Algorithmic Profiling indica que la mayoría de los errores algorítmicos citados en varios artículos examinados tiene que ver con la lectura del cuerpo humano. Y por eso los algoritmos fueron tildados de racistas o sexistas. Las tecnologías que estamos creando se basan en datos y medidas científicas que llevan consigo una larga historia de sesgos implícitos.

Las estrategias actuales para combatir esa inclinación algorítmica son problemáticas porque inducen a pensar que la información pueda ser correcta e imparcial. Sin embargo, no existe un sistema informático que no sea parcial. En 1996, Friedman y Nissenbaum, identificaron tres tipos de sesgos en estas estructuras: preexistentes (transferidos a partir de los datos recopilados); técnicos (por falta de recursos en el desarrollo de los programas informáticos); y emergentes (por cambios sociales y culturales no detectados a tiempo).

Los algoritmos y sistemas de inteligencia artificial proceden del ser humano. Siempre estarán moldeados por los valores culturales y las condiciones técnicas y sociales en las que se crearon. Es mejor tenerlo en cuenta a la hora de emplearlos para tomar decisiones.

Más en el blog de Lenovo | Reconocimiento facial: Qué es, para qué sirve, cómo funciona

Más en el blog de Lenovo | ¿Sindicato youtuber? Unión para conseguir trato más justo de Youtube

Imágenes |Amanda Dalbjörn/Unsplash, David Pupaza/Unsplash, Possessed Photography/Unsplash