¿Qué pasaría si un cobot pudiera sentir? Sentir en la acepción de “experimentar sensaciones”, claro, aún faltan décadas para que podamos plantear sentimientos virtuales. De momento sumamos el tacto como a sentidos ya adquiridos como la vista (cámara) o el oído (micrófono).

Una reciente publicación del profesor Gordon Cheng, de la Universidad Politécnica de Munich (TUM), ha confirmado que están trabajando en una piel sintética que de a los cobots un nuevo sentido sobre el que apoyarse. La usa en el robot H-1. Así podrán trabajar codo con codo con humanos, literalmente.

¿Qué son los cobots y por qué son importantes?

La palabra cobot proviene de unir las palabras collaborative y robot. También llamados co-robots, su definición tiene más de dos décadas de recorrido. Un cobot está “diseñado para ayudar a los trabajadores en el trabajo en lugar de reemplazarlos”.

Desde la perspectiva maquinista y de automatización del siglo XX, cuantos más trabajadores seamos capaces de reemplazar por robots mayores serán los beneficios empresariales (por el coste que supone el humano); pero mayor será también la seguridad en cualquier entorno (fábrica, industria, vehículo…).

Hasta hace no demasiado los robots eran máquinas peligrosas. Muestra de ello es que cualquier planta industrial se caracteriza por líneas rojas que no conviene cruzar, carteles de peligro, bandas negras y amarillas que informan del ámbito de actuación de algún robot, o botones de emergencia. Las máquinas han sido tradicionalmente buenas creando situaciones de peligro y heridos.

Los cobots, por el contrario, están diseñados para trabajar junto a los humanos sin jaulas protectoras. Priorizan la seguridad del humano frente a su propio trabajo, y de hecho se construyen y ensamblan como asistentes.

En otras palabras, si una persona entrase en contacto con el cobot, este detendría su actividad. Aunque para ello es necesario que el cobot perciba su entorno de un modo básico.

¿Cómo se siente el robot H-1?

Tradicionalmente se han usado cámaras de circuito cerrado y diferentes sensores láser para los robots industriales. Así, si un técnico atraviesa cierto umbral, se interrumpe un haz de luz y la fabricación se detiene.

Estos mecanismos en forma de botones de emergencia son muy comunes, pero el robot H-1 de la Universidad Técnica de Múnich quiere ir mucho más allá alcanzando la propiocepción.

Este robot está equipado con 1.260 células de presión y más de 13.000 sensores. Para hacernos una idea de la escala, un terminal móvil suele tener una veintena como máximo. Es obvio que todos estos sensores aportan mucha información al cobot sobre quién está cerca y dónde está la máquina. En cierto, sentido es una forma de trasladar nuestra propia biología a las máquinas.

Pensemos, por ejemplo, en cómo sabemos las personas que estamos sentados, de pie o tumbados en la cama. Al conocido mecanismo del interior del oído que nos indica la posición de la cabeza se suman cientos de miles de pequeñas fuentes distribuidas por todos nuestros músculos. Sensores de presión microscópicos que envían información al cerebro. Así funciona precisamente el H-1.

De la exterocepción a la interocepción

Los diferentes sensores que recorren su cuerpo indican al robot la posición de sus distintas partes. Es lo que en los sistemas nerviosos llamamos propiocepción o “concepción propia”. Estos sensores indican al robot la dirección o rango de movimiento de sus articulaciones.

Pero también si alguna persona está cerca (exterocepción). Vista, oído y tacto son sentidos exteroceptivos muy usados en robótica. La mezcla hace al H-1 un robot más que interesante.

Que un cobot tenga una percepción propia integrada a la percepción de otros elementos externos es clave para un trabajo eficiente y seguro. Pero también siembra la semilla (quizá futura, quizá fantástica) de la conciencia. Si los robots entienden alguna vez un chiste, será gracias a la auto-percepción.

Neurólogos como António Damásio (‘Y el cerebro creó al hombre’, 2010), neurocientíficos como David Eagleman (‘Incógnito’, 2011) o filósofos como Daniel Dennett (‘Bombas de intuición y otras herramientas de pensamiento’, 2013) sostienen que la conciencia necesita de esta “señal de retorno” propia.

¿Para qué usaremos cobots como el H-1?

El H-1 es un robot experimental y de laboratorio. Es decir, no vamos a verlo en una refinería ni trabajando codo con codo con personas en una oficina. Es una máquina para testar la tecnología, aprender, e implantarla después en máquinas reales. Así que no usaremos al H-1 más que para mejorar.

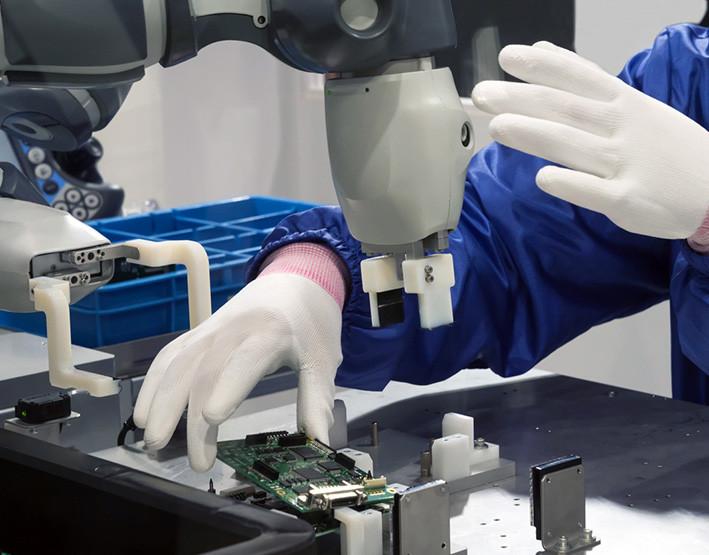

Sus avances probablemente tarden poco en llegar a la industria. Arriba podemos ver cómo un trabajador humano colabora con un robot de una línea de montaje. El robot le pasa una pieza y el humano la revisa como parte del control de calidad. ¿Cabría la posibilidad de que el robot no “viese” al humano?

De ser así este último probablemente salga mal parado debido a la fuerza de la máquina. Sus actuadores mecánicos pueden ser más potentes que nuestros músculos, y por eso la tecnología de Gordon Cheng es tan importante: la necesitamos en muchos ámbitos diferentes.

La piel sintética no tendrá uso únicamente en cobots industriales. Podremos ver sistemas parecidos en vehículos autónomos para evitar atropellos, en camas inteligentes para medir nuestra calidad del sueño o en barandillas para rastrear caídas, por ejemplo.

Al igual que ocurre con las cámaras, presentes en todo tipo de dispositivos, la piel de Cheng aumentará la seguridad en el uso de cualquier máquina; así como mejorando su propiocepción y aumentando la eficiencia que pudiese tener al realizar movimientos más precisos.

En Lenovo | Así es la piel artificial (impresa) que acabará con la experimentación cosmética en animales

Imágenes | iStock/Ales_Utovko, Astrid Eckert / TUM, iStock/JIRAROJ PRADITCHAROENKUL